Generative KI und ein Mass Customized Action Learning

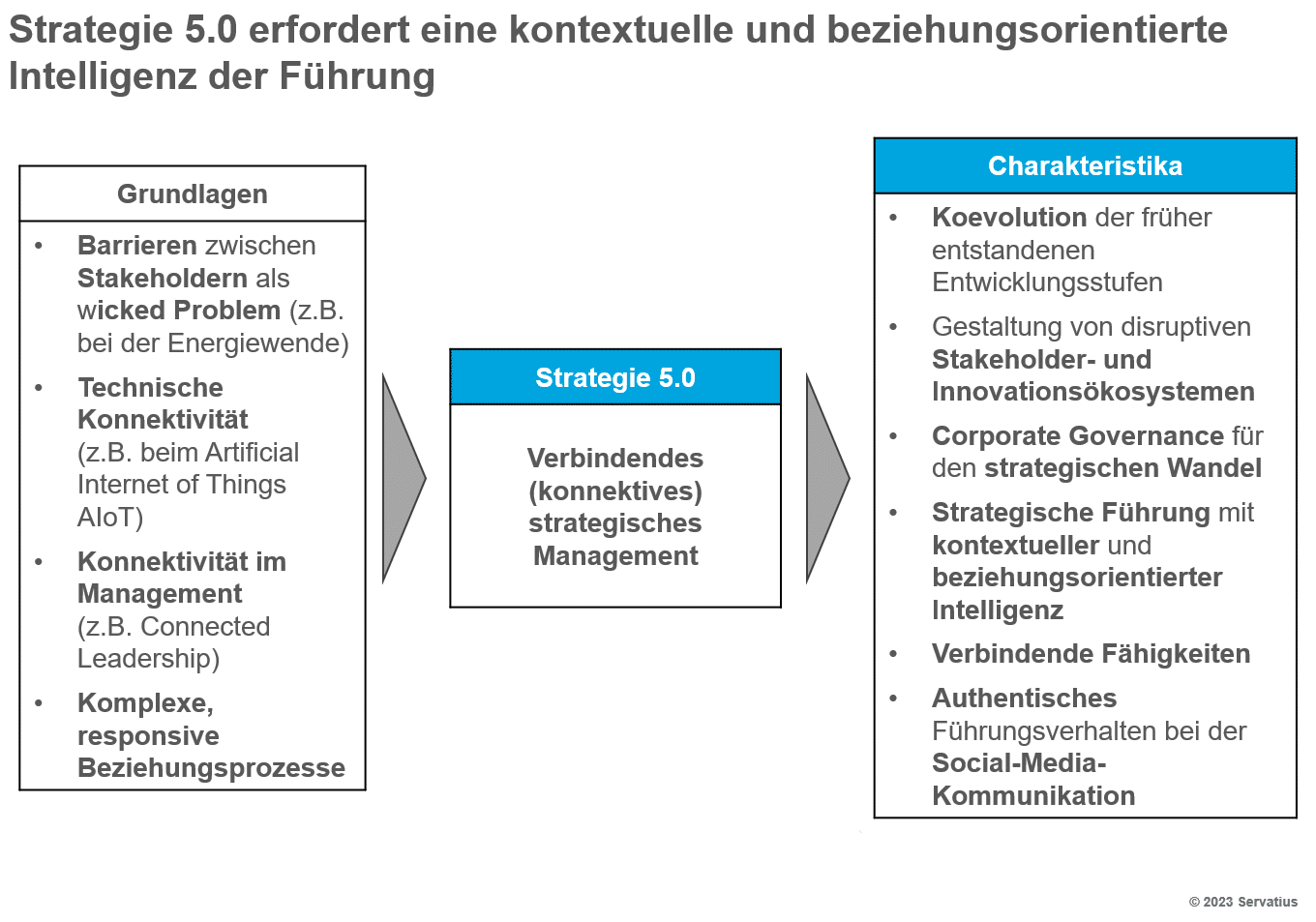

Neue Technologien wie die generative Künstliche Intelligenz (KI) und das Spatial Computing verändern die Arbeitswelt. Das deutsche Bildungs- und Weiterbildungssystem ist auf diesen Wandel nicht gut vorbereitet. Eine verbindende Strategie 5.0 strebt an, dass Organisationen diese Defizite gemeinsam mit innovativen Bildungsanbietern und der Politik überwinden.

In diesem Blogpost erläutere ich den möglichen Beitrag eines Mass Customized Action Learning zur Bewältigung des Wandels der Arbeitswelt.

Chancen und Risiken für Arbeitskräfte aufgrund der generativen KI

Wohl kaum ein Technologiethema hat in den letzten Jahren einen ähnlichen Hype ausgelöst wie die generative KI mit großen Sprachmodellen z.B. Generative Pre-Trained Transformer (GPT). Microsoft kommt das Verdienst zu, die Bedeutung dieses Trends frühzeitig erkannt, beträchtliche Summen in den GPT-Entwickler OpenAI investiert und damit begonnen zu haben, die Generative Artificial Intelligence (GenAI) in sein vorhandenes Produktprogramm zu integrieren. Das Gamechanger-Potenzial dieser Entwicklung erscheint noch bedeutender als wir in unserem 2020 erschienenen Buch geahnt haben.1 Wie sich die Spielregeln des Wettbewerbs zwischen Unternehmen und Wirtschaftsräumen verändern, ist heute noch nicht abzusehen. Von entscheidender Bedeutung wird dabei sein, die richtige Balance zwischen Innovation, Regulierung und der Befähigung der Mitarbeitenden zu finden.2 Den Experten für generative KI bietet der Arbeitsmarkt schon heute erhebliche Chancen. So könnten Autobauer die eigene Softwareentwicklung um bis zu 55 Prozent beschleunigen und gleichzeitig die Kosten um bis zu 95 Prozent senken.3

Nach einer internationalen Umfrage der Boston Consulting Group (BCG) gehen aber 40 Prozent der 12800 befragten Arbeitnehmer und Führungskräfte in 18 Ländern davon aus, dass ihr Tätigkeitsfeld künftig aufgrund von KI wahrscheinlich nicht mehr existieren wird.4 Experten prognostizieren, der Arbeitsmarkt befinde sich am Beginn eines Veränderungsprozesses, bei dem sich drei Entwicklungen überlagern:

- Durch KI entfällt eine Reihe von Jobs. Daher stellt sich die Frage, welche Arbeiten die dort Beschäftigten in der Zukunft übernehmen sollen.

- Es entsteht eine Vielzahl neuer Formen der Zusammenarbeit zwischen Menschen und Künstlicher Intelligenz. Dies betrifft die Mehrzahl der Branchen und traditionellen Funktionen.

- Es bilden sich völlig neue Tätigkeitsfelder heraus. Für alle drei Entwicklungen gilt es, geeignete Formen der Aus- und Weiterbildung zur finden.

Diese Entwicklungen haben ein großes Potenzial für sozialen Sprengstoff. Ein technologischer Umbruch, der tiefgreifender sein könnte als die industrielle Revolution, erscheint möglich. Daher wäre es wichtig, dass sich das deutsche Aus- und Weiterbildungssystem diesem Wandel stellt und praktikable Lösungen entwickelt.

Bevor ich hierauf näher eingehe, stellt sich die Frage, was die Kennzeichen der Strategie 5.0 von Microsoft sind.

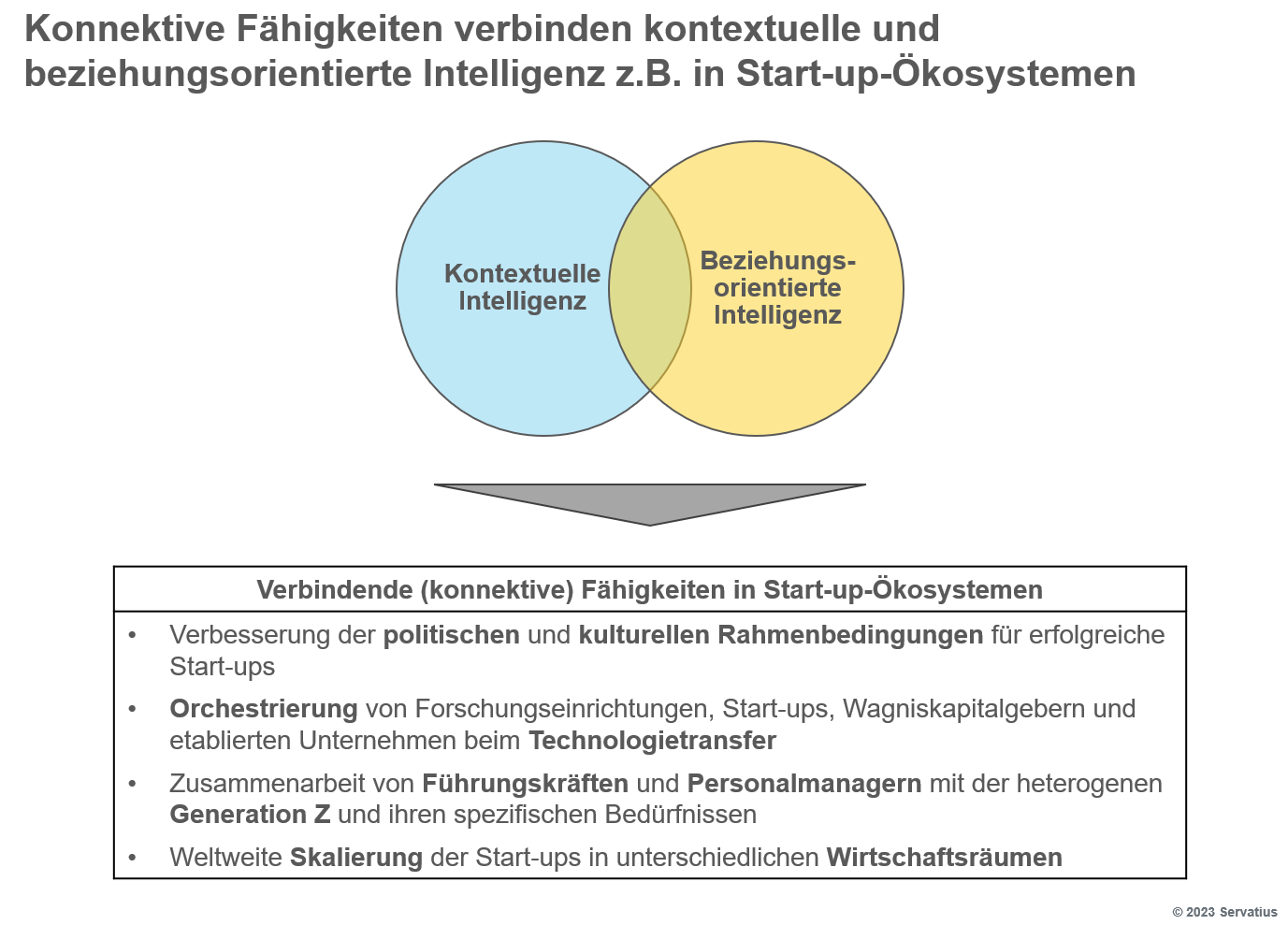

Microsofts Strategie 5.0

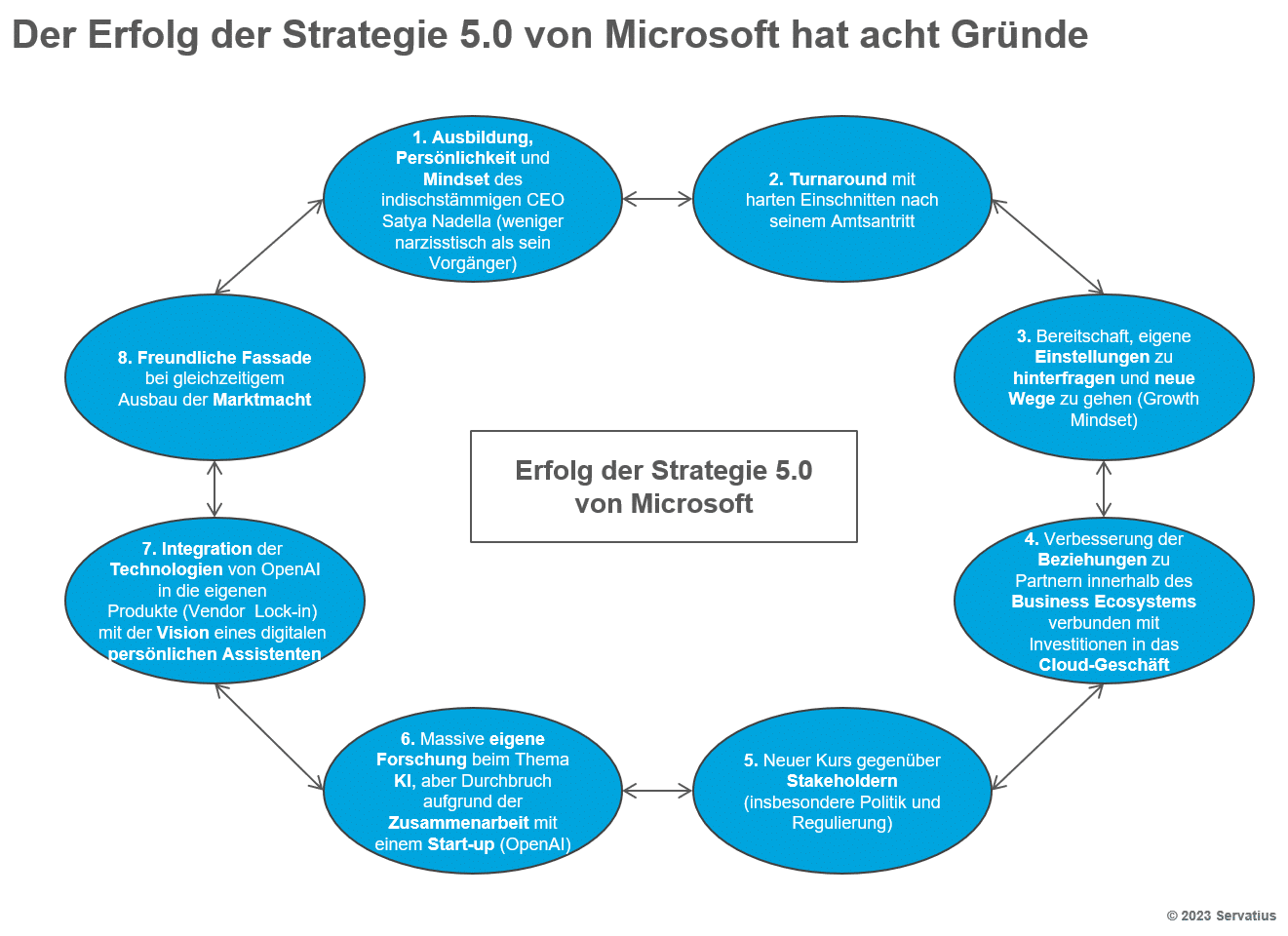

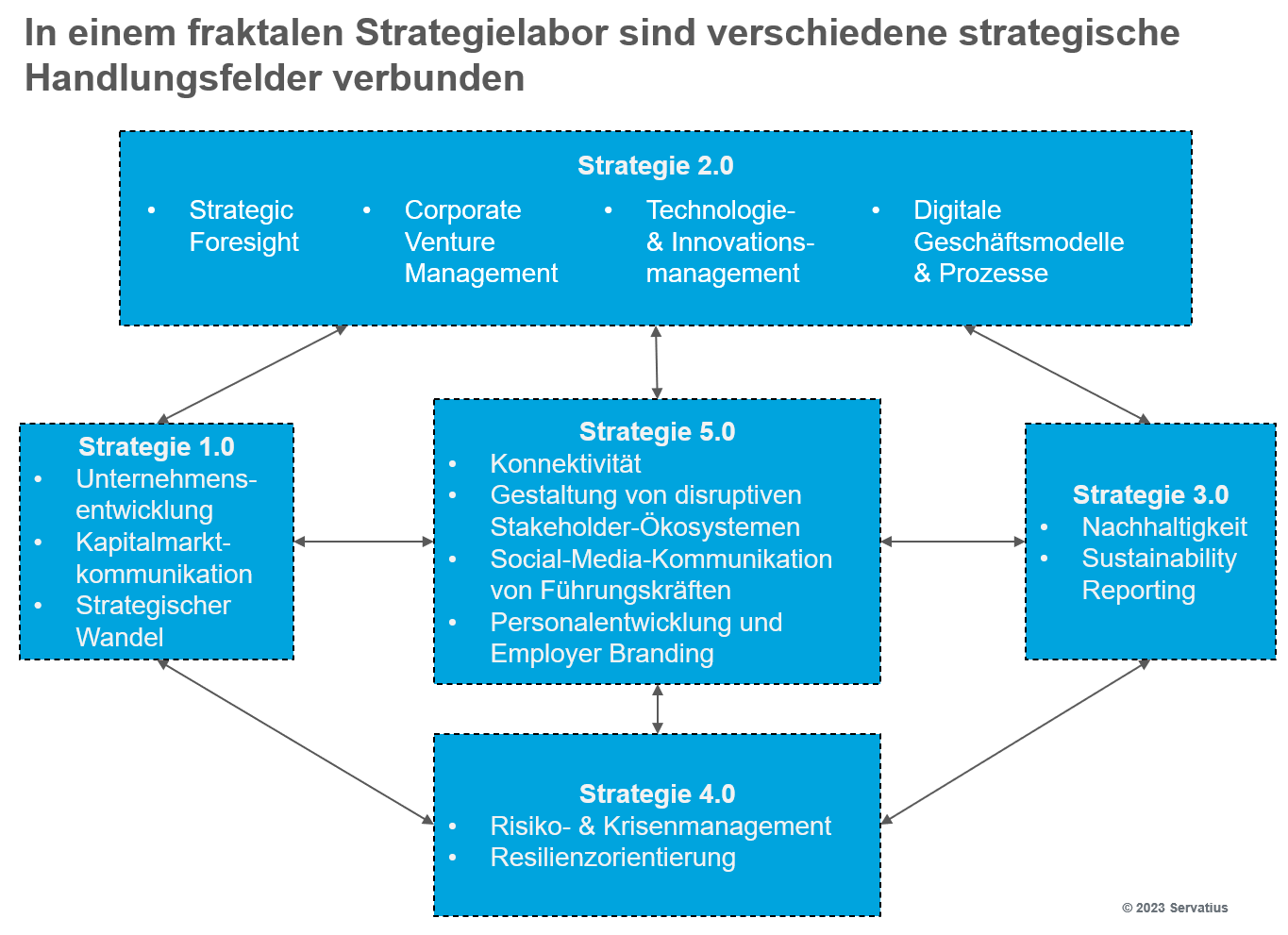

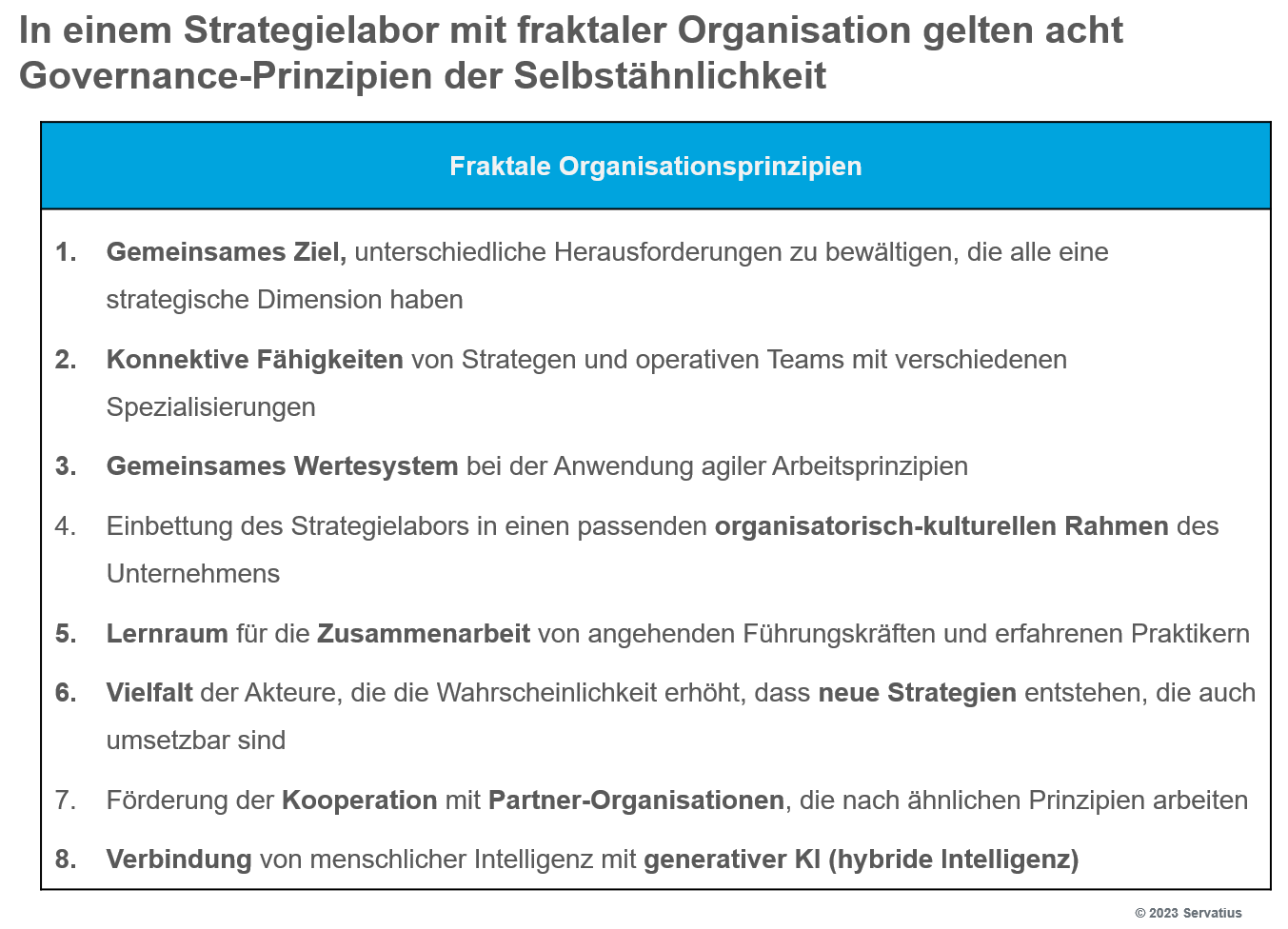

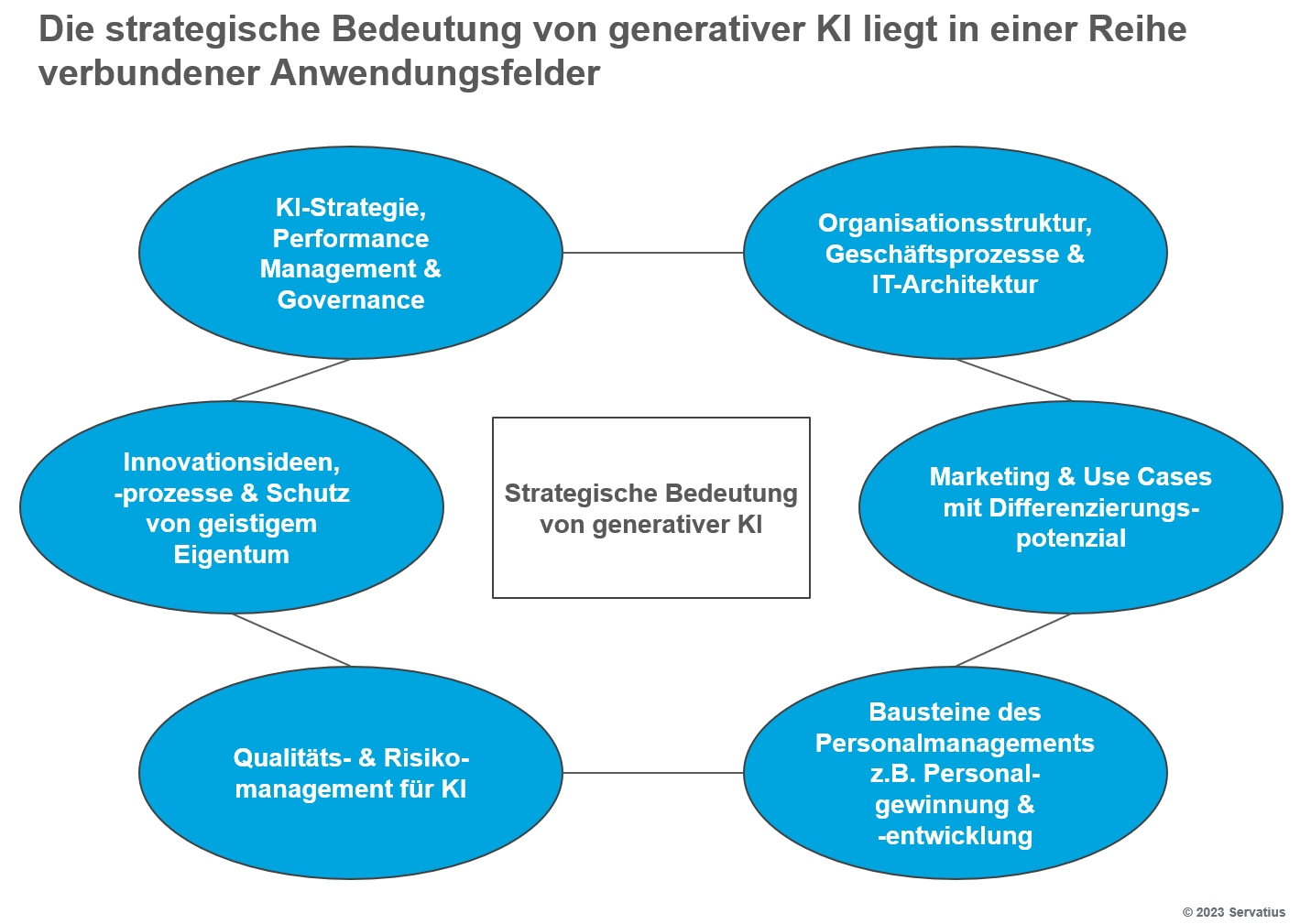

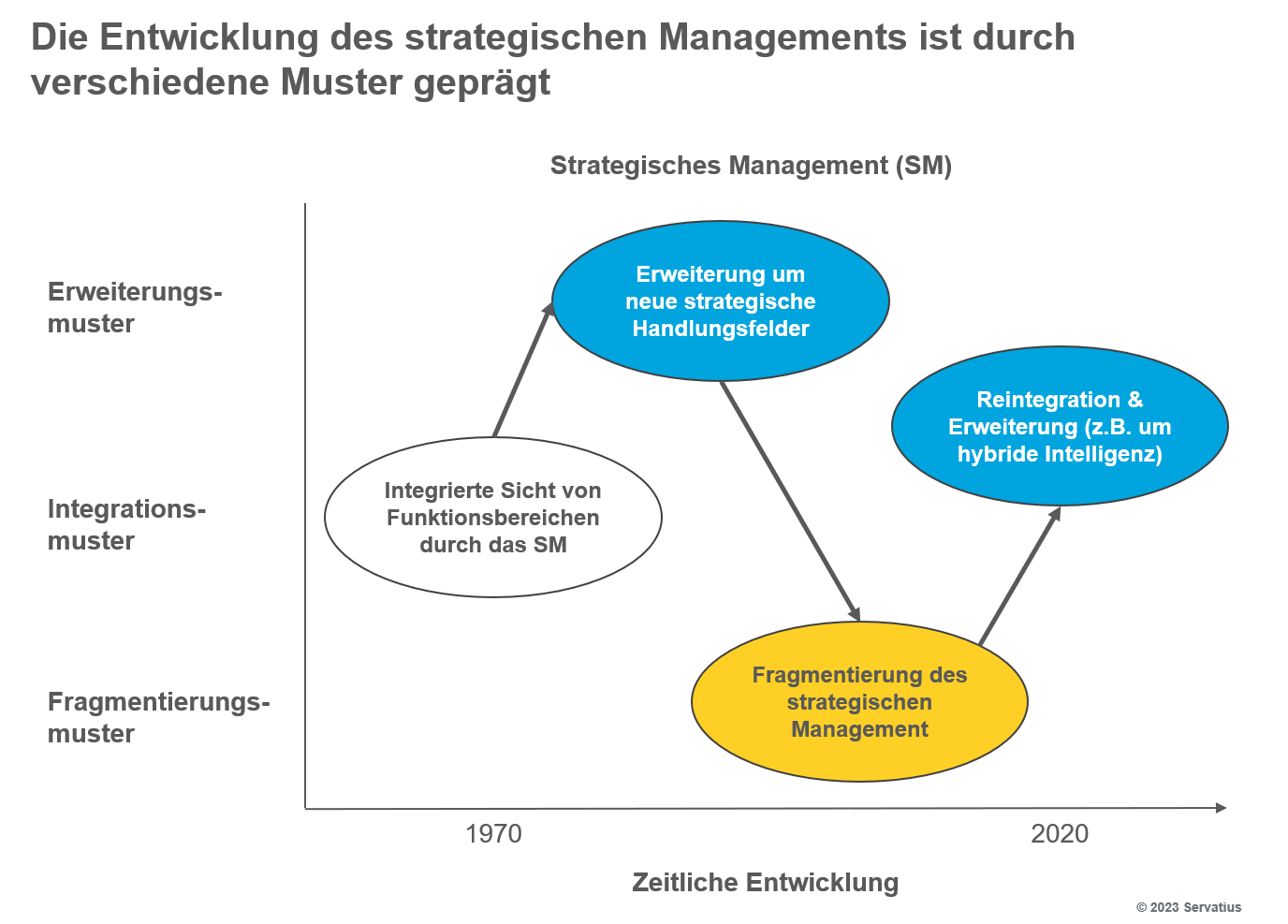

Als Strategie 5.0 bezeichnen wir die fünfte Entwicklungsstufe eines konnektiven strategischen Managements.5 Microsoft ist einer der weltweiten Vorreiter dieses bislang letzten Evolutionsschrittes, der die vorherigen Stufen verbindet. In der folgenden Abbildung sind Gründe für den Erfolg von Microsoft zusammengefasst.6

Der erste Grund liegt in der Ausbildung, Persönlichkeit und dem Mindset des indischstämmigen CEO Satya Nadella, einer Führungskraft, die deutlich weniger narzisstisch geprägt ist als sein Vorgänger.7 Unmittelbar nach seinem Amtsantritt hat Nadella einen Turnaround mit harten Einschnitten begonnen. Entscheidend ist dabei seine Bereitschaft gewesen, eigene Einstellungen zu hinterfragen und neue Wege zu gehen (Growth Mindset).8

Hinzu kommt als weiterer wichtiger Grund die Verbesserung der Beziehungen zu Partnern innerhalb des Business Ecosystems von Microsoft verbunden mit Investitionen in das Cloud-Geschäft. Typisch für seine erfolgreiche Strategie 5.0 ist ein neuer Kurs gegenüber Stakeholdern insbesondere aus den Bereichen Politik und Regulierung gewesen. Heute sucht Microsoft mit Regulierern eher den handlungsorientierten Dialog.9

Parallel dazu hat das Unternehmen seine eigene Forschung beim Thema KI massiv ausgebaut. Der Durchbruch bei großen Sprachmodellen ist dann aber aus der Zusammenarbeit mit dem anfangs eher unbekannten Start-up OpenAI entstanden. Gegenwärtig integriert Microsoft die Technologien von OpenAI in die eigenen Produkte und bindet so seine Kunden (Vendor Lock-in). Die Vision ist, der führende Anbieter von digitalen persönlichen Assistenten zu werden. Dieses Ziel verfolgt Microsoft mit einer freundlichen Fassade und einem gleichzeitigen Ausbau seiner Marktmacht.

Neben der generativen KI gibt es mit dem Spatial (räumlichen) Computing eine weitere neue Technologie, die gravierende Auswirkungen auf den Wettbewerb und den Arbeitsmarkt haben könnte.

Neue Formen der Interaktion mit dem Spatial Computing

Der bereits 2003 von dem MIT-Forscher Simon Greenworld geprägte Begriff Spatial Computing ist durch die Vorstellung der innovativen Datenbrille Apple Vision Pro bekannt geworden. Der CEO von Apple Tim Cook verfolgt das Ziel, mit diesem Mixed Reality Headset ein neues Zeitalter der Interaktion von digitaler Sphäre und realer Umgebung einzuläuten. Experten glauben, dass der heute noch von der Meta-Tochter Oculus dominierte Markt für XR-Brillen bis 2026 von 41,2 auf 100,8 Milliarden US-Dollar wachsen wird.10 An diesem Wachstum möchte Apple partizipieren.

Die Erfolgsgeschichte des Unternehmens basiert auf seinem einzigartigen Stakeholder-Ökosystem mit dem iPhone als Ankerprodukt eines Schwungrades (Flywheel), das aus den Komponenten User, App, Entwickler und eigenem Betriebssystem besteht. Auf diese Weise ist auch Apple zu einem der Vorreiter der fünften Entwicklungsstufe eines verbindenden strategischen Managements geworden.11 Diese Strategie 5.0 möchte Cook nun mit der ersten neuen Plattform in seiner Amtszeit fortschreiben.

Das ist aber nicht ohne Risiken. Im Unterschied zu den früheren Erfolgsprodukten haben sich für neuartige Datenbrillen noch keine großvolumigen Anwendungsfelder herausgebildet. Apple setzt darauf, die Sensor-Ausstattung des iPhones mit Lidar-Lasertechnologie und über 14000 Apps auf sein Mixed-Reality-Headset zu übertragen. Damit wäre das Unternehmen auf eine Zeit vorbereitet, in der Datenbrillen das Smartphone als wichtigstes persönliches Gerät ergänzen.12

Parallel dazu arbeitet Apple an einer Gegenstrategie zu generativen KI-Lösungen in der Cloud, die Microsoft gemeinsam mit dem GPT-Entwickler OpenAI vorantreibt. Dies soll mit Hilfe von Chips gelingen, die nach dem Prinzip der Model Compression arbeiten, um die Algorithmen so einzudampfen, dass sie in die Apple-Produkte passen. Die nächsten Jahre werden zeigen, wie der Wettbewerb zwischen den Digitalgiganten und ihren Stakeholder-Ökosystemen um die beste verbindende Strategie 5.0 weitergeht.

Eine spannende Frage ist, welche Rolle dabei SAP, das wertvollste deutsche Unternehmen, spielen wird. Der SAP-Chef Christian Klein braucht eine klare Roadmap für die Integration von generativer KI in die Enterprise Resource Planning (ERP-) und Customer Relationship Management (CRM-) Systeme der Zukunft. Eine wichtige Rolle in seiner Strategie spielen Kooperationen und das 2021 übernommene Business Process Intelligence (BPU-) Unternehmen Signavio.13

Insgesamt stellt sich für europäische Unternehmen die Aufgabe, die zunehmende Abhängigkeit von großen Tech-Konzernen zu verringern. Die Suche nach Lösungen sollte mit einer kritischen Ursachenanalyse der Probleme beginnen.

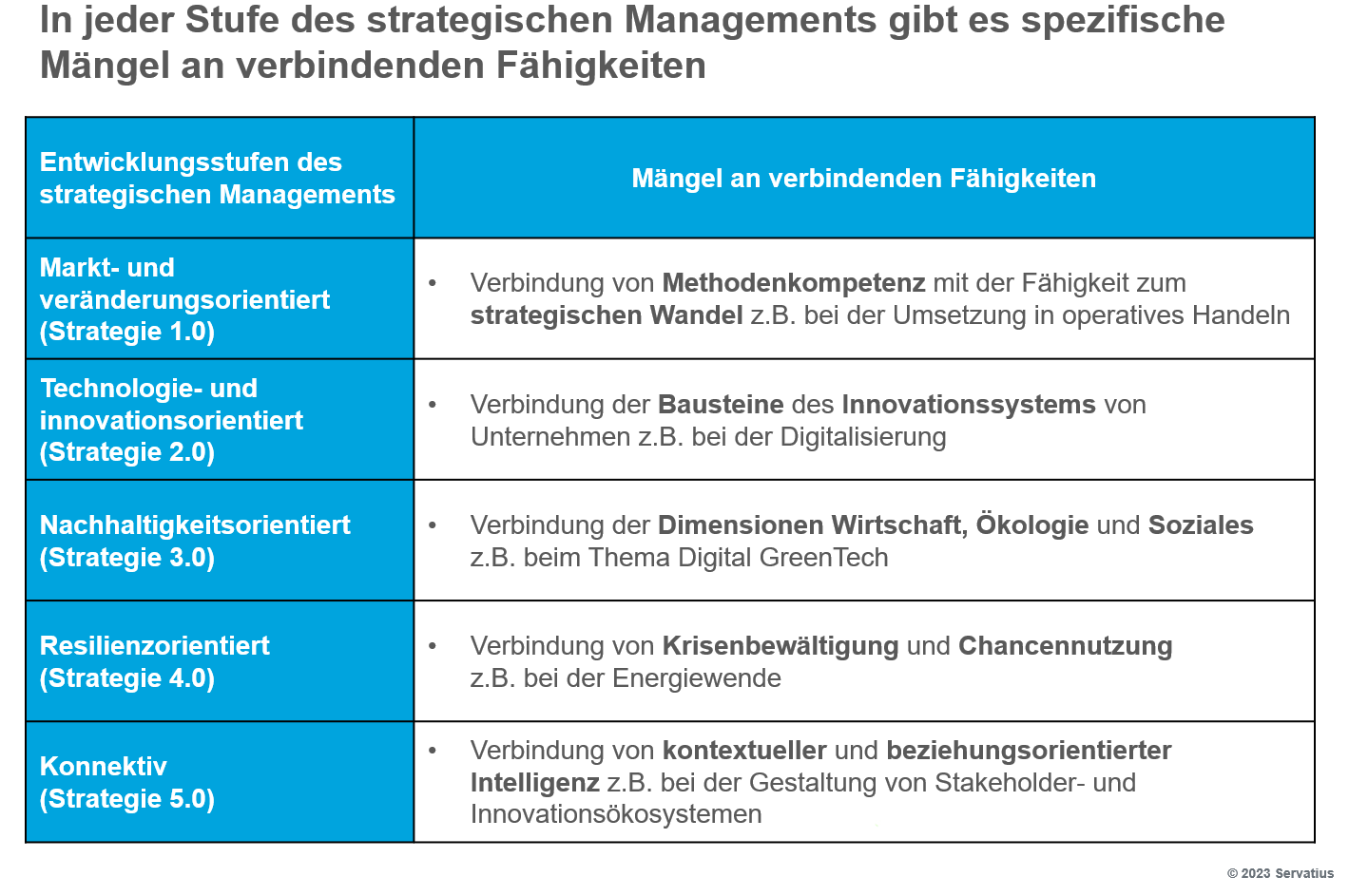

Geschwächte strategische Resilienz von Organisationen

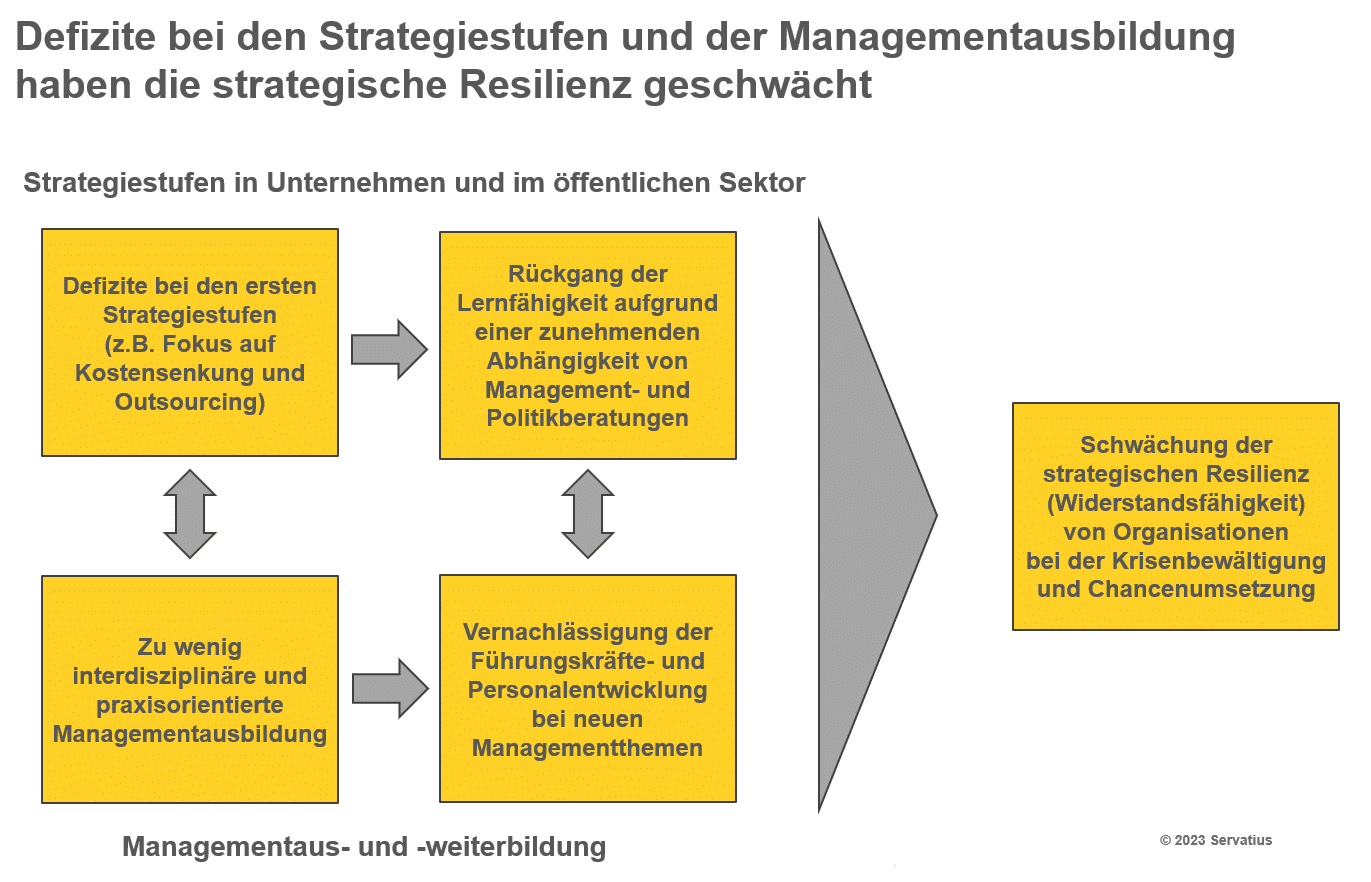

Eine solche Ursachenanalyse führt zu der These, dass sich in den letzten Jahrzehnten Defizite bei den Entwicklungsstufen des strategischen Managements und der Managementausbildung wechselseitig verstärkt haben. Diese Fehlentwicklung besteht seit der ersten Strategiestufe mit ihrem Fokus auf Kostensenkungen und einem Outsourcing wichtiger Funktionen. Dies hat zu einem Rückgang der Lernfähigkeit von Organisationen aufgrund der zunehmenden Abhängigkeit von Management- und Politikberatungen geführt.14

Der zweite Defizitbereich ist, dass die Managementausbildung über einen langen Zeitraum insbesondere an Universitäten zu wenig interdisziplinär und praxisorientiert gewesen ist. Die meisten deutschen Hochschulen haben auch die Führungskräfte- und Personalentwicklung bei neuen Managementthemen vernachlässigt. Das Ergebnis dieses Wechselspiels ist eine geschwächte strategische Resilienz (Widerstandsfähigkeit) von Organisationen bei der Krisenbewältigung und Chancennutzung.

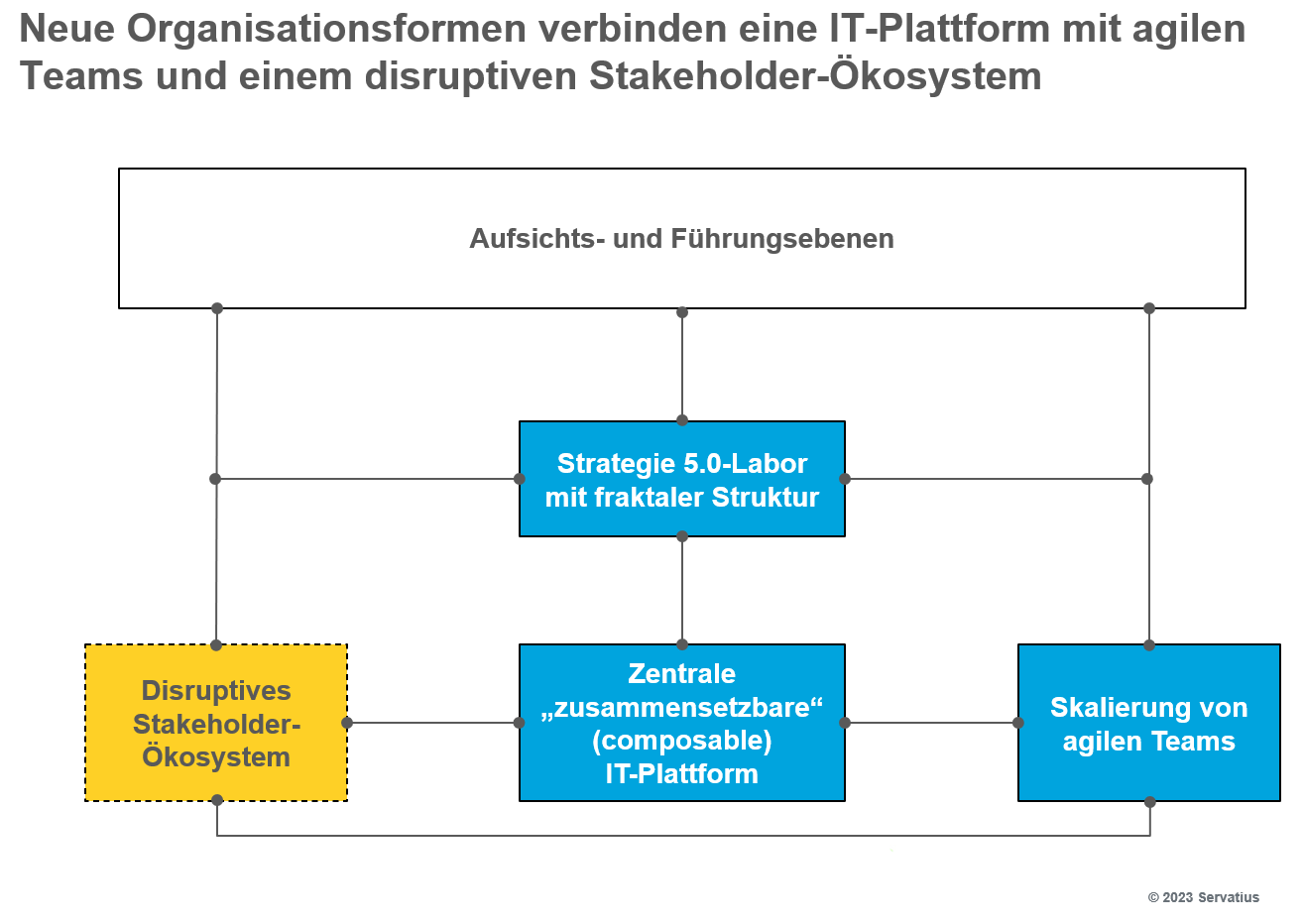

Anschauungsmaterial hierfür liefern die Schwierigkeiten von etablierten Unternehmen und öffentlichen Verwaltungen bei der Gestaltung des digitalen Wandels. Obwohl seit langem bekannt ist, dass erfolgreiche Tech-Unternehmen dabei auf eine zentrale Plattformorganisation mit agilen Teams und ein Stakeholder-Ökosystem setzen, gelingt es den meisten traditionellen Unternehmen nicht, dieses innovative Organisationskonzept an ihre spezifische Situation anzupassen.15 Der große Defizitbereich ist dabei eine zeitgemäße Governance zur Verbindung der Organisationsbausteine.

Eine der Ursachen hierfür ist, dass viele Betriebswirtschaftsstudenten nur begrenzte Programmierfähigkeiten erwerben, was die Zusammenarbeit mit Ingenieuren und Informatikern beim agilen Projektmanagement erschwert. Das Ergebnis sind Defizite von Unternehmen bei der Digitalisierung ihrer Geschäftsprozesse. Diese komplexe Aufgabe erfordert ein Zusammenspiel der Themen

- Geschäftsmodell-Innovation

- Wandel der Organisation von funktional zu prozessorientiert (Reengineering)

- Wandel der IT-Architektur

- KI-basierte Softwareunterstützung von Prozessen (Business Process Intelligence)

- Neugestaltung des Datenmanagements sowie

- organisatorisches und individuelles Lernen.

Auf eine Bewältigung dieser interdisziplinären Herausforderung sind die meisten traditionellen Studiengänge nicht ausgerichtet. Analysen in Unternehmen zeigen, dass der wichtigste Faktor, der die Anwendung von Künstlicher Intelligenz hemmt, das fehlende Know-how der Fachkräfte ist.

Ein möglicher Ausweg aus diesem Dilemma wäre die Kooperation von Unternehmen und Verwaltungen mit innovativen Bildungsanbietern. Im Folgenden erläutern wir zunächst die Schritte zur organisationsspezifischen Weiterbildung im Rahmen einer solchen Zusammenarbeit. Ein aktuelles Beispiel aus der Hochschullehre dient hierbei als Einstieg.

Schritte bei einer organisationsspezifischen Weiterbildung

Eine Prüfungsleistung im Fach Innovationsmanagement für Studierende der zur Klett Gruppe gehörenden CBS International Business School besteht in diesem Jahr in der Gestaltung von Lösungen für die Interaktion von Menschen mit generativer KI. Die Studierenden haben sehr schnell die Relevanz des Themas für ihre zukünftige Entwicklung erkannt und eine Vielzahl kreativer Ansätze erarbeitet.

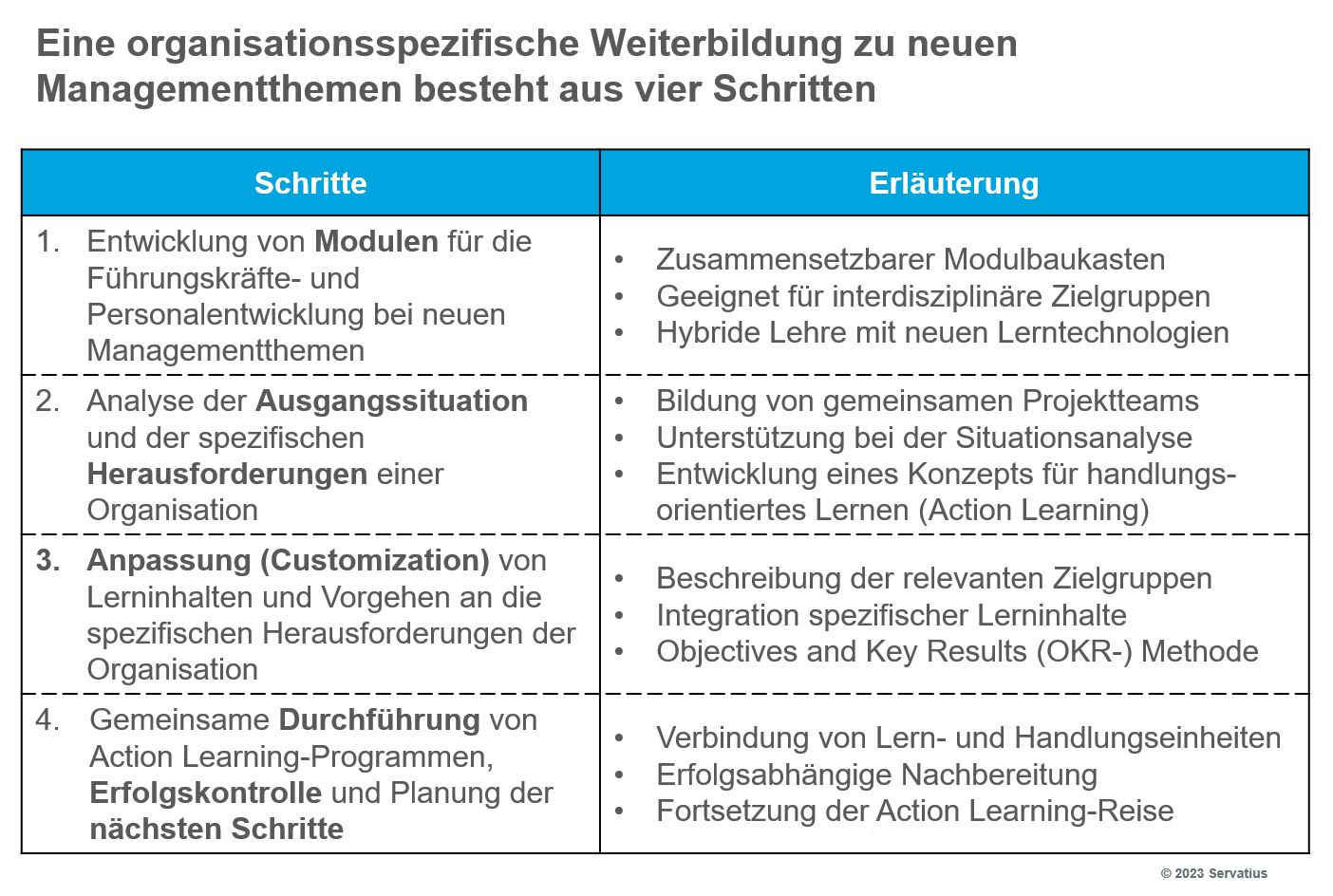

Diese Aufgabenstellung lässt sich von der Ausbildung Studierender auf eine spezifische und gleichzeitig skalierbare Weiterbildung in Organisationen übertragen.16 Ein entsprechendes Konzept besteht aus den in der Abbildung dargestellten vier Schritten. Dieses Konzept ist auch bei anderen neuen Managementthemen anwendbar.

Der erste Schritt ist die Entwicklung von relevanten Modulen für die Führungskräfte- und Personalentwicklung bei neuen Managementthemen. Auf diese Weise entsteht ein zusammensetzbarer Modulbaukasten, bei dem einzelne Microlearnings kombinierbar sind. Die Module eignen sich für interdisziplinäre Zielgruppen z.B. im Rahmen eines agilen Projektmanagements. Eine hybride Lehre verbindet Präsenz- und Online-Formate.

Hieran schließt sich im Schritt zwei eine Analyse der Ausgangssituation und der spezifischen Herausforderungen der jeweiligen Organisation an. Diese Arbeit beginnt mit der Bildung eines gemeinsamen Projektteams. Erfahrene Managementtrainer unterstützen die Klientenorganisation bei der Situationsanalyse. Auf dieser Grundlage entwickelt das Team ein maßgeschneidertes Konzept für ein handlungsorientiertes Lernen (Action Learning). Zielsetzung des Action Learning ist die Verbindung einer konkreten Problemlösung mit Lernprozessen der beteiligten Akteure.

Die Anpassung (Customization) der Lerninhalte und des Vorgehens an die spezifischen Herausforderungen findet in Schritt drei statt. Diese Arbeit beginnt mit einer Beschreibung der relevanten Zielgruppen der Organisation. Die Kernaufgabe in diesem Schritt ist eine Integration spezifischer Lerninhalte. Die Ableitung von Lernzielen und Ergebnissen kann mit Hilfe der Objectives and Key Results (OKR-) Methode erfolgen.

Den Abschluss bilden in Schritt vier die gemeinsame Durchführung von Action Learning-Programmen, eine Erfolgskontrolle und die Planung der nächsten Schritte. Eine wichtige Rolle spielt hierbei die Verbindung von Lern- und Handlungseinheiten. Innovative Lerntechnologien unterstützen eine erfolgsabhängige Nachbereitung. So kann die Organisation ihre Action-Learning-Reise fortsetzen.

Corporate Venture Management von Bildungsanbietern und EdTech Start-ups

Der Verband der Hochschullehrerinnen und Hochschullehrer für Betriebswirtschaftslehre (VHB) zeichnet in einer 2021 erschienenen Buchpublikation ein sehr positives Bild der BWL in Deutschland.17 Dabei wird aber ein wichtiger Aspekt ausgeblendet: Die Managementweiterbildung ist reif für eine Disruption durch stärker interdisziplinäre und praxisorientierte Bildungsanbieter, die zwischen der Informatik sowie den Ingenieur- und Wirtschaftswissenschaften Brücken schlagen.18 Kompetenzdefizite von Organisationen z.B. bei den Themen Digitalisierung und Nachhaltigkeit nutzen gegenwärtig Management- und Politikberatungen, deren Dienstleitungen allerdings nicht primär auf die Personalentwicklung ausgerichtet sind. Die entstandene Lücke könnte ein Corporate Venture Management von Bildungsanbietern und Educational Technology (EdTech) Start-ups schließen. Ein Treiber dieser Entwicklung ist der Megatrend Konnektivität mit seiner technischen und seiner Management-Dimension.19

Beim Corporate Venture Management beteiligen sich etablierte Unternehmen an Start-ups, um die Vorteile von Erfahrung, Kapitalkraft und Innovationsfähigkeit zu verbinden.20 Dieser Ansatz ist in Deutschland mit erheblicher Verzögerung angekommen, erfreut sich inzwischen aber wachsender Beliebtheit.

Der größte private Bildungsanbieter in Deutschland ist die Klett Gruppe. Zur Klett Gruppe gehören auch Hochschulen, für die ich seit über einem Jahrzehnt als externer Dozent tätig bin. Diese sind mit praxisorientierten Bachelor- und Masterprogrammen sehr erfolgreich. Deutlich schwerer tun sich deutsche Bildungsanbieter mit den Märkten für eine Customized Management Education und Massive Open Online Courses (MOOC). Eine erfolgversprechende Strategie könnten Bildungsanbieter gemeinsam mit Managementtrainern und EdTech Start-ups realisieren. In eine solche Partnerschaft bringen z.B. Anbieter von dualen Studiengängen ihr Dozentennetzwerk mit vorhandenen Lehrinhalten und gute Geschäftsbeziehungen zu einer Vielzahl häufig mittelständischer Arbeitgeber der dual Studierenden ein. Bei diesen dualen Studiengängen ist vom ersten Tag an eine enge Verbindung zwischen Theorie und Praxis gewährleistet.

So vermitteln wir z.B. den Wirtschaftsingenieur-Studenten der CBS gleich zu Beginn ihrer Ausbildung ein ganzheitliches Verständnis der Funktionsweise von innovativen Geschäftsmodellen und erfolgreichen agilen Organisationen. Anhand von praktischen Beispielen erläutern wir verschiedene Laufbahnmodelle wie die Fachlaufbahn und die Führungslaufbahn. Eine wichtige Ergänzung hierzu ist das Testen der Talentleitmotive der Studierenden, die so eine Orientierung erhalten, welche persönlichen Spezialisierungen für sie passend sind.21 Angesichts des Fachkräftemangels ist dieses Angebot der Hochschule für die Arbeitgeber der dualen Studenten eine gute Differenzierungsmöglichkeit im Personalmarketing.

Der Fachkräftemangel ist auch ein wichtiger Treiber der Entwicklung des weltweiten EdTech-Marktes, für den Experten bis 2030 ein jährliches Wachstum von 13,6 Prozent auf 348,4 Milliarden US-Dollar prognostizieren. Dieser Markt ist stark durch Start-ups geprägt. So haben Venture Capital-Unternehmen 2020 allein in den USA 1,78 Milliarden US-Dollar in junge, auf Educational Technology spezialisierte Unternehmen investiert.

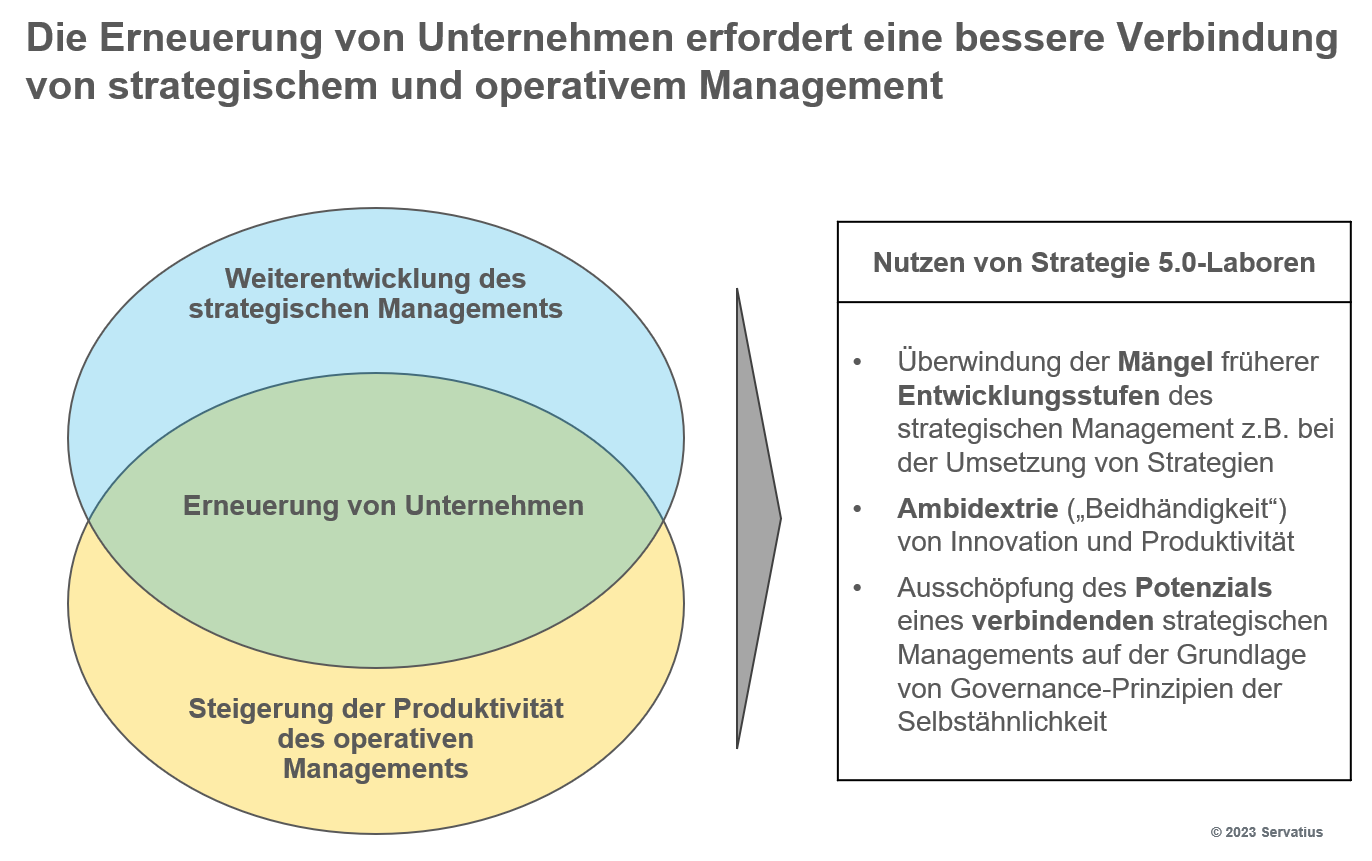

Universitäten sollten die skizzierten Disruptionsherausforderungen des Bildungsmarktes als Chance zur eigenen Weiterentwicklung begreifen. Innovative Technologien wie die generative KI und das Spatial Computing sind ein Anlass, über eine grundlegende Neuausrichtung der Aus- und Weiterbildung von Informatikern, Ingenieuren und Betriebswirten nachzudenken. Die verbindende fünfte Entwicklungsstufe des strategischen Managements liefert hierfür den passenden Rahmen. Bei einer solchen Neuausrichtung ist die jeweilige strategische Ausgangssituation der Universität in den Segmenten Customized Management Education und MOOC-Plattformen zu berücksichtigen.

Eine Möglichkeit zur Weiterentwicklung wäre z.B. die Etablierung von Lehrunternehmen in der Region, mit denen Universitäten kooperieren. In der Medizin spielen Lehrkrankenhäuser eine wichtige Rolle bei der Aus- und Weiterbildung von Ärzten. Ein ähnliches Konzept könnte für die Managementlehre entstehen. Dabei ergänzen erfahrene Praktiker aus Unternehmen und Verwaltungen die meist sehr theoretisch orientierten Universitätsprofessoren. Ein Teil der Aus- und Weiterbildung würde von den Universitäten in die Lehrunternehmen verlagert. Das Ziel dieses Ansatzes wäre, eine Win-Win-Situation für beide Seiten zu schaffen.

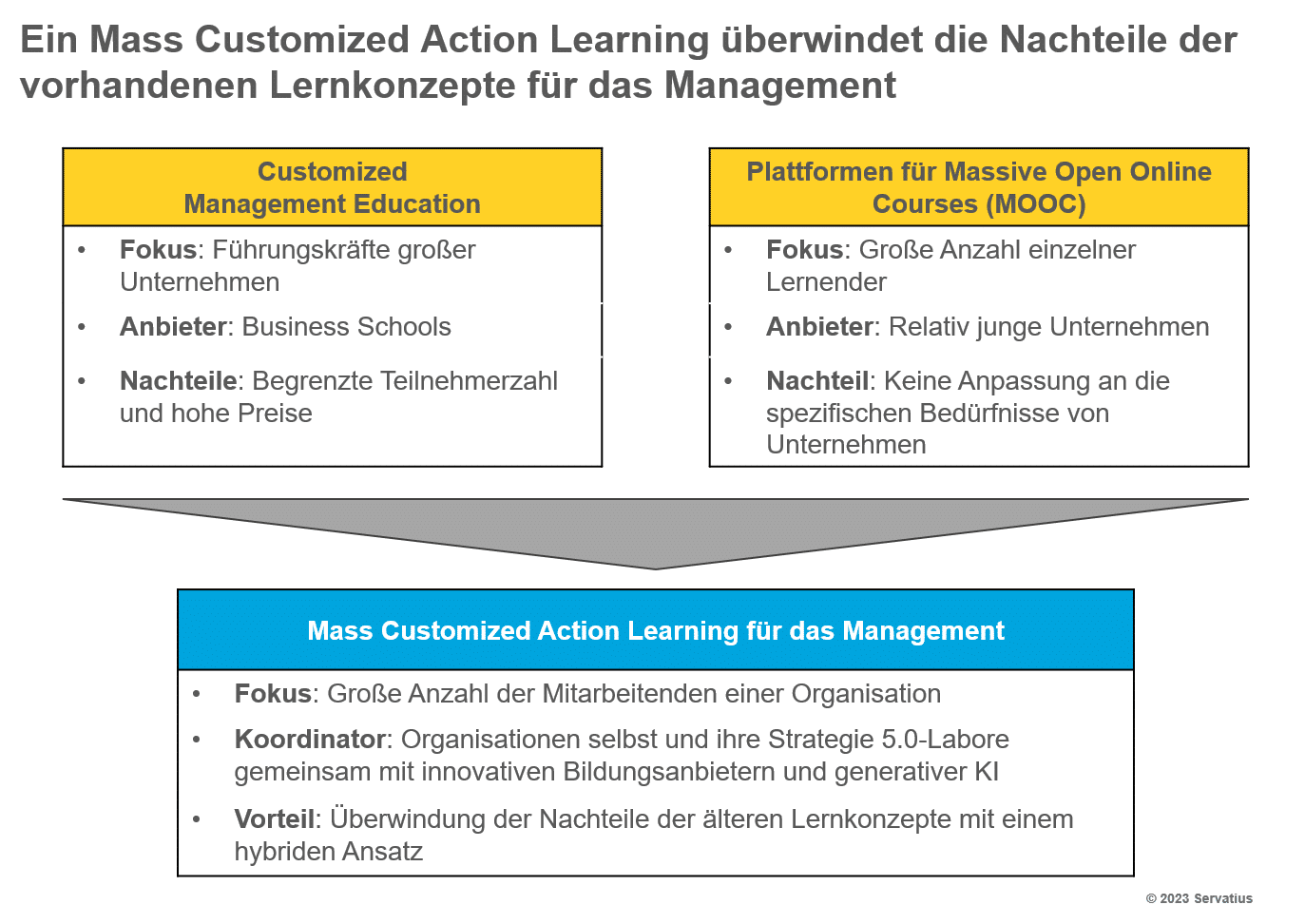

Im Folgenden skizzieren wir kurz die klassische Customized Management Education und die rasante Entwicklung von Plattformen für Massive Open Online Courses (MOOC). Hieraus leiten wir die Vorteile eines Mass Customized Action Learning (MCAL) in der Managementaus- und -weiterbildung ab.

Entwicklung zu einem Mass Customized Action Learning

Eine bedeutende Rolle bei der organisationsspezifischen Weiterbildung von Führungskräften großer Unternehmen spielen internationale Business Schools. An der Spitze des Ranking der Financial Times für 2023 im Segment „Executive Education Custom“ liegt Duke Corporate Education gefolgt von Insead, HEC Paris und IESE.22 Immerhin hat es die Berliner ESMT auf Rang fünf geschafft. Unter den besten 75 Anbietern weltweit finden sich drei weitere Business Schools aus Deutschland. Allerdings machen die begrenzte Anzahl von Kursteilnehmern und die Preispolitik der Hochschulen eine breit angelegte Weiterbildung von Mitarbeitern z.B. beim Thema generative KI nahezu unmöglich. Eine Alternative hierzu sind MOOC-Plattformen.

Im Oktober 2011 haben Stanford-Forscher drei kostenlose Onlinekurse veröffentlicht. Jeder dieser Kurse erreichte mehr als 100000 Lernende und die Medien prägten den Begriff MOOC. Inzwischen bieten über 1200 Hochschulen weltweit öffentlich Onlinekurse an. Parallel dazu sind global tätige MOOC-Plattformen wie Coursera, EdX und FutureLearn sowie eine Vielzahl nationaler Anbieter von MOOC-Plattformen entstanden. Bis 2021 haben weltweit mehr als 220 Millionen Lernende mindestens einen MOOC belegt.23

Der Nachteil dieser relativ kostengünstigen Alternative zu traditionellen Business Schools war in der Vergangenheit, dass keine Anpassung an die spezifischen Bedürfnisse eines Einzelnen oder einer Organisation erfolgt ist. Das ändert sich gerade. Eine Kombination der Vorteile der beiden Lernwelten des Managements erscheint mit Hilfe des Mass Customized Action Learning erreichbar. Diese hybride Lernform verknüpft Elemente des Präsenz- und des Onlinelernens.

In der Industrie verbindet das Anfang der 1990er Jahre von Joseph Pine entwickelte Konzept der Mass Customization die Vorteile der Massenproduktion mit kundenindividuellen Produkten und Dienstleistungen.24 Wichtige Impulse für eine Weiterentwicklung der kundenindividuellen Massenproduktion sind von dem Aachener BWL-Professor und Mitgründer von Competivation Frank Piller ausgegangen.25 Dieses Konzept ist auf die Managementaus- und -weiterbildung übertragbar. Hier überwindet es die Nachteile der Customized Management Education und der MOOC-Plattformen. Ein Anwendungsfokus könnte bei neuen Managementthemen wie der generativen KI liegen, bei der ein Up- und Re-Skilling einer großen Anzahl von Mitarbeitenden in Organisationen erforderlich ist, die unterschiedliche individuelle Lernbedürfnisse haben. Koordinatoren eines solchen Mass Customized Action Learning (MCAL) für das Management sind die Organisationen selbst gemeinsam mit innovativen Bildungsanbietern, die zunehmend generative KI einsetzen. Eine entscheidende Rolle spielt dabei das handlungsorientierte Lernen aller Akteure, die sich mit ihren Kompetenzen in die Prozesse einbringen. Auf diese Weise erlebt das Action Learning eine Weiterentwicklung und Anpassung an aktuelle Herausforderungen.26

Ein Beispiel für die Anwendung von generativer KI durch MOOC-Plattformen liefert die in den USA ansässige Khan Academy, die mit ihren Khamingo-Programmen auf der Basis von ChatGPT jedem Lernenden einen persönlichen Tutor und jedem Lehrer einen persönlichen Assistenten anbietet. In Singapur hat das Bildungsministerium die sich hieraus ergebenden Chancen erkannt und stellt Pädagogen die erforderlichen Ressourcen zur Verfügung.27 Dies zeigt das Potenzial eines Mass Customized Action Learning für Zielgruppen von der Grundschule bis zu Führungskräften.

Unsere Erfahrungen mit der Anwendung dieses Konzepts bei einer Reihe neuer Managementthemen sind bislang sehr positiv. Neben dem Erfahrungsaustausch mit weiteren Klientenorganisationen und ihren entstehenden Strategie 5.0-Laboren28 sind wir am Ausbau unseres Innovationsökosystems zu diesem spannenden Thema interessiert. Ein Vorbild ist die von Max Viessmann initiierte Netzwerk-Plattform Maschinenraum mit Sitz in Berlin, wo Familienunternehmen, Start-ups und deutsche Risikokapitalgesellschaften zusammenarbeiten.

Generative KI als Anwendungsfeld und Ermöglicher neuer Lernformen

Im Folgenden fassen wir Gründe zusammen, warum das Mass Customized Action Learning für die Weiterbildung von Personen, Teams und großen Gruppen gut geeignet erscheint. Die generative KI ist dabei sowohl Anwendungsfeld als auch Ermöglicher. Diese Begründung sollte auch Zweifler überzeugen, die gemeinsamen Anstrengungen zu erhöhen.

Ein wichtiger Aspekt ist, dass die hohe Dynamik der generativen KI eine laufende Weiterentwicklung der Lerninhalte erforderlich macht. Der notwendige Austausch mit führenden Wissenschaftlern, Politikern und Medien ist von einem einzelnen Managementtrainer kaum zu leisten. Daher wäre es wirtschaftlich sinnvoll, dass die Lehrenden ihre Lerninhalte gemeinsam mit persönlichen GenAI-basierten Assistenten aktualisieren.

Der weltweit große Bedarf an Aus- und Weiterbildung zum Thema generative KI rechtfertigt Investitionen von Bildungsanbietern, wenn deren Geschäftsmodelle ein Erfolgspotenzial haben. Unter den Anbietern wird sich der Wettbewerb verschärfen. Es bleibt abzuwarten, welche Kooperationsmodelle sich dabei durchsetzen.

Das Nutzenversprechen der Mass Customization gegenüber One size fits all-Ansätzen ist, dass es wirtschaftlich gelingt, die Lerninhalte und das Vorgehen sowohl auf der individuellen Ebene der Lernenden als auch auf der Organisationsebene mit Hilfe von GenAI-basierten Tutoren an die spezifischen Bedingungen der Kunden anzupassen. Ein Ermöglicher dabei sind innovative Lerntechnologien. Dies spricht für die Zusammenarbeit von Bildungsanbietern mit EdTech Start-ups und KI-Unternehmen.

Außerdem eignet sich das Thema gut für eine Verbindung von Lernen und Handeln. Dieses Potenzial schöpft das Action Learning aus, bei dem Lehrende und Lernende ihre Kompetenzen einbringen. Daher sollte auch die Weiterbildung der Managementtrainer eine hohe Priorität haben.

Auch die Lehrenden erweitern mit jedem Projekt ihre Erfahrungen. Deshalb ist ein großes Netzwerk an qualifizierten Managementtrainern für den Bildungsanbieter ein wichtiger Wettbewerbsvorteil.

Natürlich haben auch die internationalen Managementberatungen die Chancen erkannt, die der entstehende Markt für sie eröffnet. Eine bessere Befähigung von Organisationen und Mitarbeitenden verringert jedoch die Abhängigkeit von Consultants und erhöht die eigene Resilienz. Dies spricht dafür, stärker auf neue Formen der Weiterbildung zu setzen.

Erfinderland auf der Verliererstraße?

Es ist relativ wenig bekannt, dass wichtige theoretische Grundlagen der generativen KI bereits in den 1990er Jahren von dem deutschen Informatik-Professor Jürgen Schmidthuber und seinem Team an der TU München gelegt worden sind. Als derjenige, der das Rennen um Bildgeneratoren schon vor OpenAI gestartet hat, gilt Professor Björn Ommer, der an der Ludwig-Maximilians-Universität München forscht und den Bildgenerator Stable Diffusion entwickelt hat. Hieraus ist das bei Open-Source-KI führende Start-up StabilityAI entstanden, das bei der letzten Finanzierungsrunde mit einer Milliarde Dollar bewertet worden ist.29 Wie auch in anderen Technologiefeldern kommen wichtige Erfinder im Bereich der generativen KI also aus Deutschland.

Umso bedauerlicher ist das bereits in unserem Buch zum Thema KI behandelte Versagen der deutschen Politik.30 Zwar hat 2018 die damalige Bundesregierung Ansätze zu einer nationalen KI-Strategie formuliert, die 2020 fortgeschrieben worden ist. Die Opposition wirft der Ampel-Koalition vor, das Thema generative KI verschlafen zu haben. Jörg Bienert vom KI-Bundesverband kritisiert die fehlende Koordination und fordert eine abgestimmte Position am besten ausgehend vom Kanzleramt. Das Bundesforschungsministerium hat inzwischen einen Aktionsplan vorgelegt, den Experten als zu schwammig und zu wenig umsetzungsorientiert kritisieren. Im Unterscheid zu dem nicht erfolgversprechenden Auftreten der deutschen Politik positioniert der britische Premierminister Rishi Sunak sein Land als Alternative zu den als zu drakonisch empfundenen KI-Regeln der EU und dem Laissez-faire-Verhalten der USA.31

Eine Möglichkeit für Deutschland und die EU, diese Verliererstraße zu verlassen, wäre die verbesserte Zusammenarbeit von Wissenschaft, Politik, Wirtschaft und Gesellschaft im Rahmen eines verbindenden innovations-, wirtschafts- und bildungspolitischen Narrativs.32 Leider ist eine solche KI-Strategie 5.0 der Politik gegenwärtig nicht einmal in Ansätzen erkennbar.

Unternehmen, die dabei sind aufzuholen

Trotz der Defizite der Politik gibt es auch in Deutschland beim Thema generative KI Unternehmen, die dabei sind aufzuholen. Hierzu gehört z.B. Bosch, wo man gemeinsam mit dem Heidelberger Start-up Aleph Alpha an einem eigenen Sprachmodell arbeitet, das mit Unternehmensdaten gefüttert wird. Die bei Bosch verantwortliche Geschäftsführerin Tanja Rückert betrachtet die KI als Schlüsseltechnologie und Innovationsbooster.

Um das Vertrauen in generative KI zu stärken, hat Bosch konzernintern das Start-up AI-Shield initiiert. Dessen Schutzschild analysiert die Benutzereingaben und sorgt dafür, dass Unternehmensrichtlinien eingehalten werden.

Eine zentrale Rolle spielt dabei die Weiterbildung in großem Maßstab. So hat Bosch bereits 26500 Mitarbeiter in KI geschult.33 Auch andere Unternehmen starten gegenwärtig eine Weiterbildungsoffensive. Hierbei setzt Vodafone auf individualisierte Angebote, die eine neue Lernplattform vorschlägt.34 Ansätze wie diese nähren die Hoffnung, dass einige Unternehmen in Deutschland eben nicht auf der Verliererstraße sind, sondern angefangen haben, das Anwendungspotenzial der generativen KI auszuschöpfen.

Fazit

- Durch die generative KI verändert sich der Arbeitsmarkt grundlegend. Dies erfordert geeignete Formen der Aus- und Weiterbildung.

- Ein Vorreiter sowohl bei der fünften Entwicklungsstufe des strategischen Managements (Strategie 5.0) als auch beim Thema generative KI ist Microsoft.

- Der Strategie 5.0-Vorreiter Apple plant, mit seinem neuen Mixed Reality Headset das Smartphone als wichtigstes persönliches Gerät zu ergänzen. Zwischen den großen Digitalunternehmen verschärft sich der Wettbewerb.

- Diese Entwicklungen treffen in Deutschland auf Organisationen, deren strategische Resilienz geschwächt ist. Hierzu haben Defizite in der Managementaus- und -weiterbildung beigetragen.

- Ein Lösungsansatz ist die verbesserte Customized Management Education. Zu diesem Ansatz haben wir ein bewährtes Vorgehenskonzept beschrieben.

- Eine wichtige Rolle kann dabei die Zusammenarbeit von Bildungsanbietern mit Managementtrainern und EdTech Start-ups spielen.

- Ein Mass Customized Action Learning wird durch generative KI ermöglicht, die gleichzeitig ein Anwendungsfeld für die neue Lernform ist.

- Deutschland braucht dringend eine grundlegende überarbeitete KI-Strategie, die die Politikfelder Innovation, Wirtschaft und Bildung verbindet.

- Unternehmen die aufholen zeigen, wie notwendig beim Thema KI eine Weiterbildungsoffensive ist.

Literatur

[1] Kaufmann, T., Servatius, H.G.: Das Internet der Dinge und Künstliche Intelligenz als Game Changer – Wege zu einem Management 4.0 und einer digitalen Architektur, Wiesbaden 2020

[2] Anger, H. et al.: Unternehmer fordern rasche Regulierung. In: Handelsblatt, 13. Juni 2023, S. 8-9

[3] Hubik, F., Tyborski, R.: KI könnte Software-Dilemma lösen. In: Handelsblatt, 12. Juni 2023, S. 20

[4] Klöckner, J., Specht, I.: Die Angst der Deutschen vor KI. In: Handelsblatt, 7. Juni 2023, S. 8-9

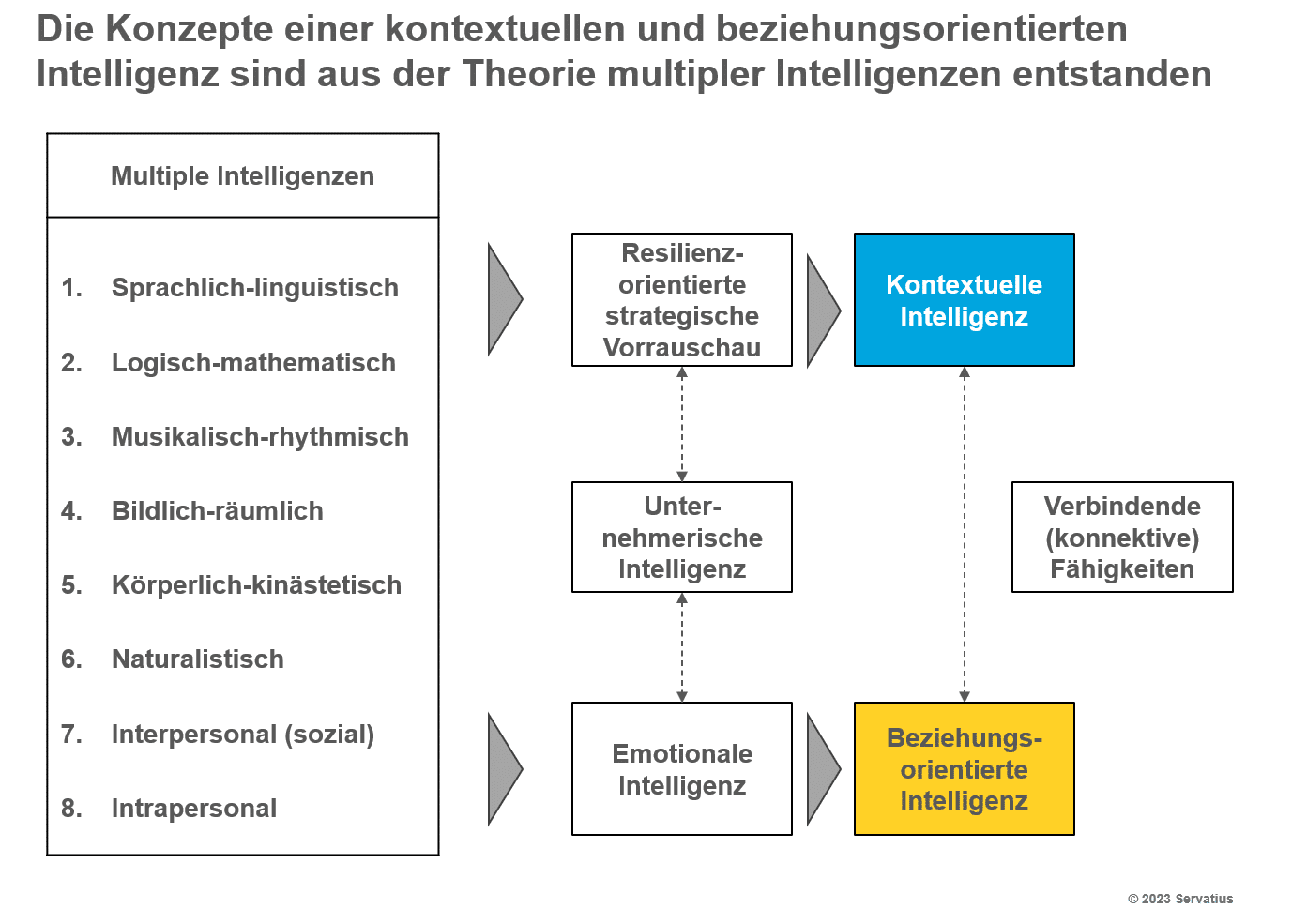

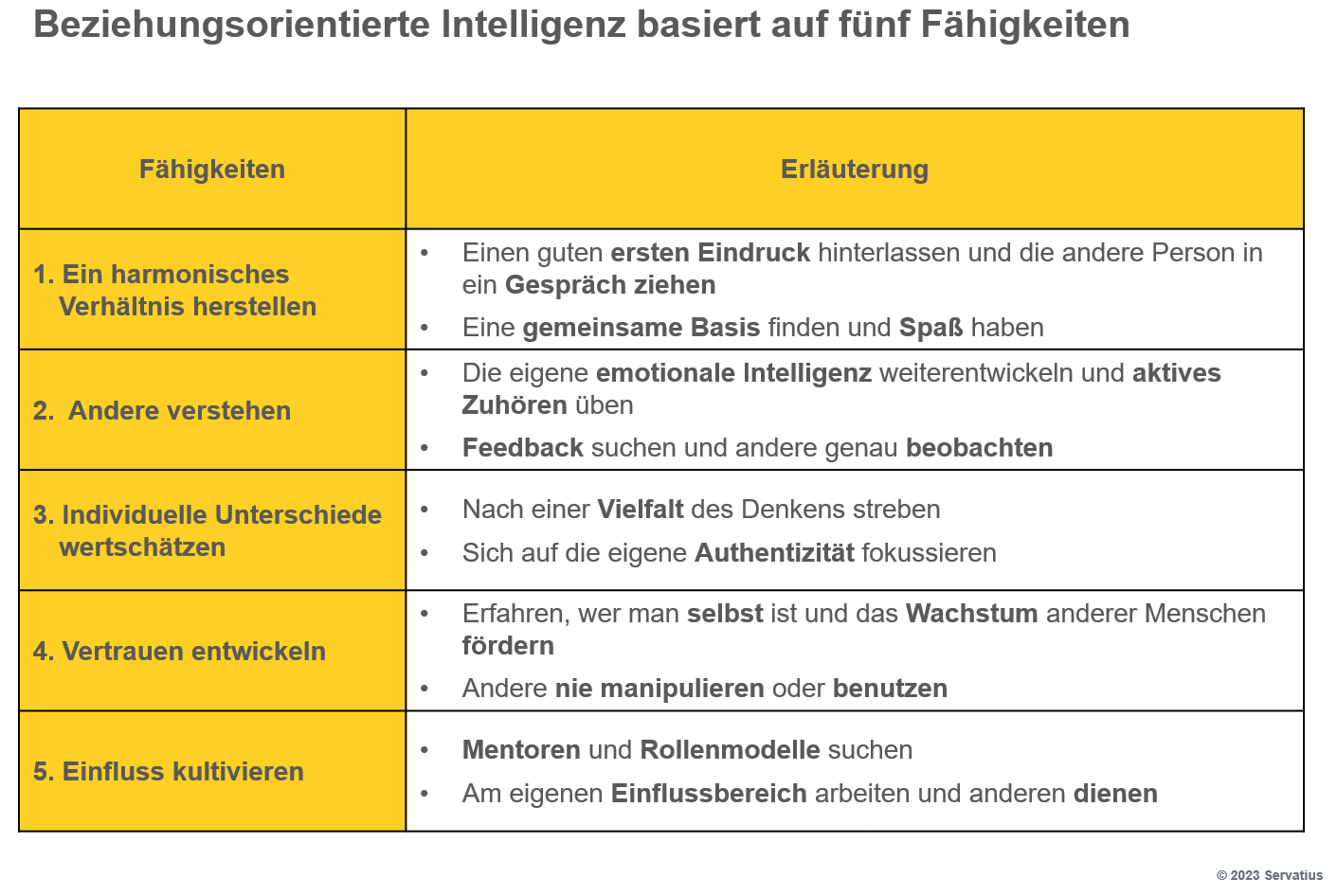

[5] Servatius, H.G.: Strategisch führen mit kontextueller und beziehungsorientierter Intelligenz. In: Competivation Blog, 14.03.2023

[6] Kerkmann, C., Scheuer, S.: Alles eine Frage der Einstellung. In: Handelsblatt, 14./15./16. Juli, S. 42-49

[7] Kets de Vries, M.: The Leader on the Couch – A Clinical Approach to Changing People and Organizations, Chichester 2006

[8] Dweck, C.: Mindset – The New Psychology of Success, New York 2006

[9] Hemmati, M.: Multi-Stakeholder Processes for Governance and Sustainability – Beyond Deadlock and Conflict, London 2002

[10] Scheuer, S.: Apples nächste große Wette. In: Handelsblatt, 7. Juni 2023, S. 24-25

[11] Servatius, H.G.: Strategie 5.0 zur Bewältigung der neuen Herausforderungen. In: Competivation Blog, 28.06.2022

[12] Rest, J.: Knall oder Fall. In: Manager Magazin, Juni 2023, S. 24-30

[13] Kyriasoglou, C.: Cloud und leise. In: Manager Magazin, August 2023, S. 48-52

[14] Mazzucato, M., Collington, R.: Die große Consulting Show – Wie die Beratungsbranche unsere Unternehmen schwächt, den Staat unterwandert und die Wirtschaft vereinnahmt, Frankfurt 2023

[15] Servatius, H.G.: Die Ressourcen-Plattform mit agilen Teams als neue Organisationsform. In: Competivation Blog, 12.01.2021

[16] Fellenz, M.R., Hoidn, S., Brady, M. (Hrsg.): The Future of Management Education, London 2022

[17] Schwenker, B. et al., Erfolgsfaktor Betriebswirtschaftslehre – Was sie leistet und warum wir sie brauchen, München 2021

[18] Kaufmann, Servatius: a.a.O., S. 81 ff.

[19] Servatius, H.G.: Der Megatrend Konnektivität und seine Treiber. In: Competivation Blog, 26.10.2021

[20] Servatius, H.G.: New Venture Management – Erfolgreiche Lösung von Innovationsproblemen für Technologie-Unternehmen, Wiesbaden 1988

[21] Rath, T., Conchie, B.: Strengths Based Leadership – Great Leaders, Teams, and Why People Follow, New York 2008

[22] Financial Times: Business School Ranking – Executive Education Custom 2023

[23] Shah, D., Pickard, L., Ma, R.: Massive List of MOOC Platforms Around the World, 10. April 2023

[24] Pine, B.J.: Mass Customization – The New Frontier in Business Competition, Boston 1993

[25] Piller, F.T.: Kundenindividuelle Massenproduktion – Die Wettbewerbsstrategie der Zukunft, München 1998

[26] Mc Gill, I., Beaty, L.: Action Learning – A Guide for Professional, Management and Educational Development, 2. Aufl., London 1995

[27] Gillmann, B.: Ein Privatlehrer für jeden Schüler. In: Handelsblatt, 30. Juni/ 1./2. Juli 2023, S. 28

[28] Servatius, H.G.: Fraktale Organisation von Strategie 5.0-Laboren. In: Competivation Blog, 28.03.2023

[29] Böschen, M.: Die Produktivitätsmaschine. In: Manager Magazin, Juli 2023, S. 92-96

[30] Kaufmann, Servatius, a.a.O., S. 205 ff.

[31] Rieke, T.: Auf dem Weg zur technologischen Supermacht. In: Handelsblatt, 4. Juli 2023, S. 14-15

[32] Servatius, H.G.: Auf dem Weg zu einem neuen wirtschaftspolitischen Narrativ. In: Competivation Blog, 16.05.2022

[33] Holzki, L.: Bosch setzt auf eigenes KI-Modell à la ChatGPT. In: Handelsblatt, 11./12./13. August 2023, S. 26-27

[34] Obmann, C.: So werden Ihre Mitarbeiter KI-fit. In: Handelsblatt, 11./12./13. August 2023, S. 52-53